COMMUNIQUÉ DE PRESSE

15 mai 2024

Apple annonce de nouvelles fonctionnalités d’accessibilité, notamment le suivi oculaire, l’haptique musicale et les raccourcis vocaux

Les nouvelles fonctions d’accessibilité d’Apple, qui deviendront disponibles cette année, comprennent le suivi oculaire, qui permet aux utilisateurs de naviguer sur leur iPad ou iPhone en se servant uniquement de leurs yeux.

TORONTO (ONTARIO) Apple a annoncé aujourd’hui de nouvelles fonctionnalités d’accessibilité qui deviendront accessibles cette année, notamment le suivi oculaire, qui permet aux utilisateurs souffrant d’un handicap physique de contrôler l’iPad ou l’iPhone avec leurs yeux. En outre, l’haptique musicale proposera aux utilisateurs sourds ou malentendants une nouvelle façon d’écouter de la musique grâce au moteur Taptic de l’iPhone. Les raccourcis vocaux permettront aux utilisateurs d’effectuer des tâches en émettant un son personnalisé. La fonction Vehicle Motion Cues permettra de réduire le mal des transports lors de l’utilisation de l’iPhone ou de l’iPad dans un véhicule en mouvement. En outre, d’autres fonctions d’accessibilité viendront s’ajouter à visionOS. Ces fonctionnalités jumellent la puissance du matériel et des logiciels Apple, en exploitant les puces d’Apple, l’intelligence artificielle et l’apprentissage automatique sur l’appareil, afin de poursuivre l’engagement pris par Apple depuis des décennies de concevoir des produits pour tout le monde.

« Nous sommes profondément convaincus que le pouvoir de transformation de l’innovation permet d’enrichir nos vies », déclare Tim Cook, président-directeur général d’Apple. « C’est pourquoi, depuis près de 40 ans, Apple se fait le champion de la conception inclusive en intégrant l’accessibilité au cœur de son matériel et de ses logiciels. Nous repoussons sans cesse les limites de la technologie, et ces nouvelles fonctionnalités se font l’écho de notre engagement de longue date à offrir la meilleure expérience possible à tous nos utilisateurs. »

« Chaque année, nous innovons en matière d’accessibilité », déclare Sarah Herrlinger, directrice principale du service Accessibility Policy and Initiatives chez Apple. « Ces nouvelles fonctionnalités auront une incidence sur la vie de nombreux utilisateurs, en leur offrant de nouvelles façons de communiquer, de contrôler leurs appareils et de se déplacer dans le monde. »

Le suivi oculaire arrive sur iPad et iPhone

Grâce à l’intelligence artificielle, le suivi oculaire propose aux utilisateurs une option intégrée pour naviguer sur l’iPad et l’iPhone en se servant seulement de leurs yeux. Conçu pour les utilisateurs ayant un handicap physique, le suivi oculaire utilise la caméra frontale pour se configurer et se calibrer en quelques secondes. Grâce à l’apprentissage automatique sur l’appareil, toutes les données utilisées pour configurer et contrôler cette fonctionnalité sont conservées en toute sécurité sur l’appareil et ne sont pas communiquées à Apple.

Le suivi oculaire fonctionne avec les applications iPadOS et iOS, et ne nécessite pas de matériel ou d’accessoires supplémentaires. Grâce à cette fonctionnalité, les utilisateurs peuvent naviguer dans les éléments d’une application et utiliser le contrôle d’attente pour activer chaque élément, en accédant à des fonctions supplémentaires telles que des boutons physiques, des glissements et d’autres gestes uniquement avec leurs yeux.

L’haptique musicale rend les chansons plus accessibles

L’haptique musicale est une nouvelle façon pour les utilisateurs sourds ou malentendants de découvrir la musique sur iPhone. Lorsque cette fonction d’accessibilité est activée, le moteur Taptic de l’iPhone ajoute des tapotements, des textures et des vibrations raffinées au son de la musique. L’haptique musicale fonctionne avec des millions de chansons du catalogue Apple Music et sera disponible sous forme d’interface de programmation d’applications pour les développeurs afin de rendre la musique plus accessible dans leurs applications.

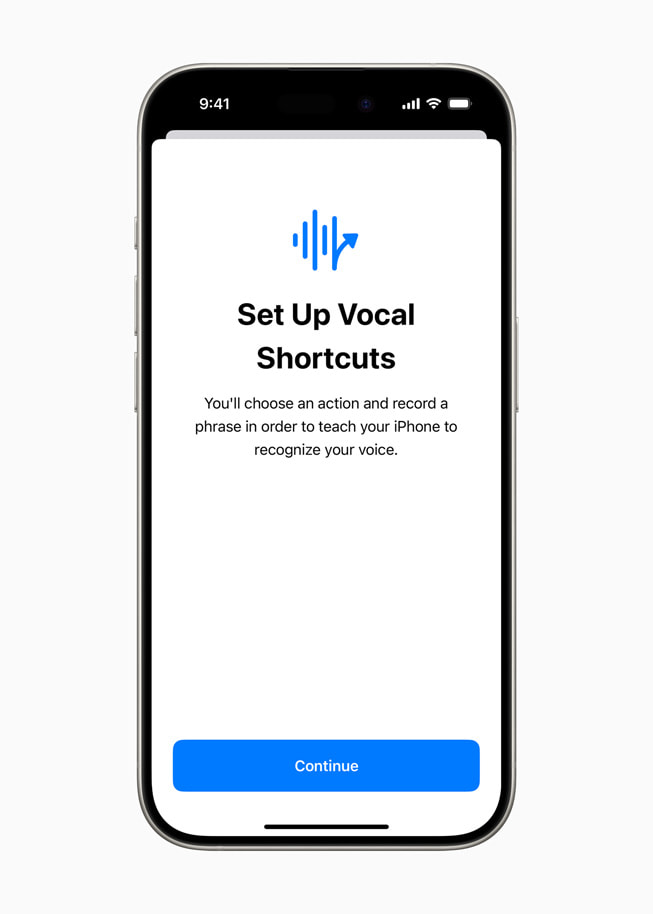

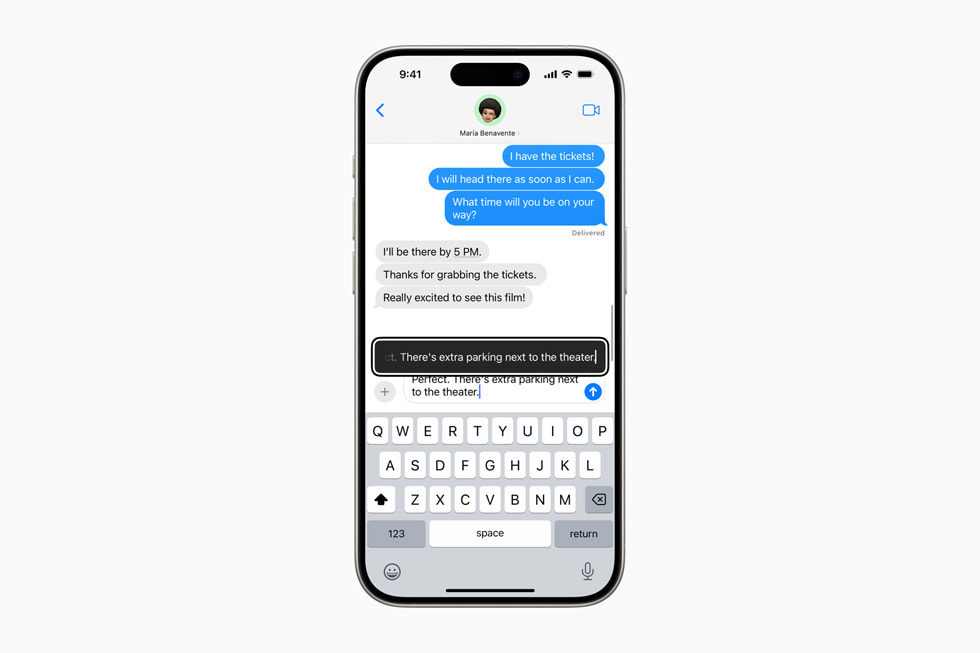

De nouvelles fonctionnalités pour un large éventail d’élocutions

Avec les raccourcis vocaux, les utilisateurs d’iPhone et d’iPad peuvent attribuer des énoncés personnalisés que Siri peut comprendre pour activer des raccourcis et effectuer des tâches complexes. La nouvelle fonctionnalité Listen for Atypical Speech permet aux utilisateurs d’améliorer la reconnaissance vocale pour un plus large éventail d’élocutions. Elle utilise l’apprentissage automatique sur l’appareil pour reconnaître les modes d’expression vocale de l’utilisateur. Ces fonctionnalités sont conçues pour les utilisateurs atteints de maladies acquises ou progressives qui touchent la parole, telles que la paralysie cérébrale, la sclérose latérale amyotrophique ou un accident vasculaire cérébral. Elles offrent un nouveau niveau de personnalisation et de contrôle en s’appuyant sur les nouvelles fonctionnalités d’iOS 17 pour les utilisateurs qui ne parlent pas ou qui sont en train de perdre leur capacité à parler.

« L’intelligence artificielle a le potentiel d’améliorer la reconnaissance vocale pour des millions de personnes ayant une élocution atypique. Nous sommes donc ravis qu’Apple mette ces nouvelles fonctions d’accessibilité à la disposition des consommateurs », affirme Mark Hasegawa-Johnson, responsable du projet d’accessibilité vocale au Beckman Institute for Advanced Science and Technology de l’Université de l’Illinois à Urbana-Champaign. « Le projet d’accessibilité vocale a été conçu comme un vaste effort appuyé par la collectivité afin d’aider les entreprises et les universités à rendre la reconnaissance vocale plus robuste et plus efficace, et c’est grâce à des défenseurs de l’accessibilité comme Apple que le projet est possible. »

La fonction Vehicle Motion Cues peut contribuer à réduire le mal des transports

Vehicle Motion Cues est une nouvelle expérience pour iPhone et iPad pouvant contribuer à réduire le mal des transports pour les passagers de véhicules en mouvement. Selon les recherches, le mal des transports est généralement causé par un conflit sensoriel entre ce qu’une personne voit et ce qu’elle ressent, ce qui peut empêcher certains utilisateurs d’utiliser confortablement leur iPhone ou leur iPad dans un véhicule en mouvement. Avec la fonction Vehicle Motion Cues, des points animés sur les bords de l’écran représentent les changements de mouvement du véhicule, ce qui contribue à réduire les conflits sensoriels sans nuire au contenu principal. Grâce aux capteurs intégrés à l’iPhone et à l’iPad, Vehicle Motion Cues reconnaît si un utilisateur se trouve dans un véhicule en mouvement et réagit en conséquence. La fonction peut être réglée de manière à s’afficher automatiquement sur l’iPhone, ou peut être activée ou désactivée dans le Centre de contrôle.

CarPlay se dote de la commande vocale et d’autres mises à jour pour l’accessibilité

Les fonctions d’accessibilité qui seront intégrées à CarPlay comprennent la commande vocale, les filtres de couleur et la reconnaissance sonore. Grâce à la commande vocale, les utilisateurs peuvent naviguer dans CarPlay et contrôler les applications avec leur seule voix. La reconnaissance sonore permet aux conducteurs ou passagers sourds ou malentendants d’activer des alertes pour être avertis des klaxons et des sirènes. Pour les utilisateurs daltoniens, les filtres de couleur facilitent l’utilisation de l’interface CarPlay, avec des fonctions d’accessibilité visuelle supplémentaires telles que le texte en gras.

Des fonctionnalités d’accessibilité pour visionOS

Cette année, les fonctions d’accessibilité de visionOS incluront des sous-titres en direct dans l’ensemble du système afin d’aider tout le monde, dont les utilisateurs sourds ou malentendants, à suivre les dialogues parlés dans les conversations en direct et dans les fichiers audio des applications. Grâce aux sous-titres en direct pour FaceTime sur visionOS, un public élargi peut désormais facilement profiter d’une expérience unique de connexion et de collaboration au moyen de leur Persona. Apple Vision Pro ajoutera la possibilité de déplacer les sous-titres à l’aide de la barre de fenêtre pendant une Apple Immersive Video, ainsi que la prise en charge d’appareils auditifs « Made for iPhone » et de processeurs cochléaires. Les mises à jour concernant l’accessibilité visuelle comprendront l’ajout d’options de réduction de la transparence, d’inversion intelligente et de diminution des lumières clignotantes à l’intention des utilisateurs ayant des troubles de vision ou souhaitant éviter les lumières vives et les clignotements fréquents.

Ces fonctions s’ajoutent aux dizaines de fonctions d’accessibilité déjà disponibles dans Apple Vision Pro, qui propose un système de saisie flexible et une interface intuitive conçue pour un large éventail d’utilisateurs. Des fonctionnalités telles que VoiceOver, Zoom et Color Filters peuvent également permettre aux utilisateurs aveugles ou malvoyants d’accéder à l’informatique spatiale, tandis que des fonctionnalités telles que Accès guidé peuvent aider les utilisateurs ayant un handicap cognitif. Les utilisateurs peuvent contrôler Vision Pro avec n’importe quelle combinaison de leurs yeux, de leurs mains ou de leur voix, avec des fonctions d’accessibilité telles que le contrôle de sélection, les actions sonores et le contrôle d’attente. Ces fonctions peuvent également aider les personnes souffrant d’un handicap physique.

« Apple Vision Pro est sans aucun doute la technologie la plus accessible que j’aie jamais utilisée », déclare Ryan Hudson-Peralta, concepteur de produits, consultant en accessibilité et cofondateur de Equal Accessibility LLC, située à Détroit. « Je suis né sans mains et incapable de marcher, je sais que le monde n’a pas été conçu en tenant compte de moi. Je trouve donc incroyable de voir comment visionOS fonctionne. Cela témoigne de l’importance d’une conception accessible et inclusive. »

Autres nouveautés

- Pour les utilisateurs aveugles ou malvoyants, VoiceOver comprendra de nouvelles voix, un rotor vocal flexible, un contrôle du volume personnalisé et la possibilité de personnaliser les raccourcis clavier de VoiceOver sur Mac.

- La loupe offrira un nouveau mode de lecture et la possibilité de lancer facilement le mode de détection au moyen du bouton Action.

- Les utilisateurs du braille bénéficieront d’une nouvelle façon de démarrer et de rester dans Saisie braille à l’écran pour un contrôle et une édition de texte plus rapides; de la disponibilité de la langue japonaise pour la Saisie braille à l’écran; de la prise en charge du braille multiligne avec Dot Pad; et l’option de choisir différentes tables d’entrée et de sortie.

- Pour les utilisateurs malvoyants, Hover Typing affiche un texte plus grand lors de la saisie dans un champ de texte, dans la police et la couleur préférées de l’utilisateur.

- Pour les utilisateurs qui risquent de perdre leur capacité à parler, Voix personnelle sera disponible en chinois mandarin. Les utilisateurs qui éprouvent de la difficulté à prononcer ou à lire des phrases complètes pourront créer une Voix personnelle grâce à des phrases abrégées.

- Pour les utilisateurs qui ne parlent pas, Parole en direct comprendra des catégories et une compatibilité simultanée avec les sous-titres en direct.

- Pour les utilisateurs ayant un handicap physique, Virtual Trackpad pour AssistiveTouch permet aux utilisateurs de contrôler leur appareil en utilisant une petite partie de l’écran comme un pavé tactile redimensionnable.

- Le contrôle de sélection inclura l’option d’utiliser les caméras de l’iPhone et de l’iPad pour reconnaître les gestes du doigt comme des interrupteurs.

- La commande vocale prendra en charge les vocabulaires personnalisés et les mots complexes.

Célébrez la Journée mondiale de sensibilisation à l’accessibilité avec Apple

Cette semaine, Apple présente de nouvelles fonctionnalités, des sélections triées sur le volet et bien plus encore pour célébrer la Journée mondiale de sensibilisation à l’accessibilité :

- Tout au long du mois de mai, certains Apple Store organiseront des séances gratuites pour aider les clients à explorer et à découvrir les fonctions d’accessibilité intégrées dans les produits qu’ils aiment. L’Apple Piazza Liberty à Milan présentera les talents à l’origine de la campagne virale « Assume that I can » pour la Journée mondiale du syndrome de Down. Disponibles tout au long de l’année dans les Apple Stores du monde entier, les réservations de groupe Today at Apple permettent à des groupes d’amis et de membres de la famille, aux écoles et aux groupes communautaires de découvrir ensemble les fonctions d’accessibilité.

- Le raccourci ajoute Calming sounds, qui diffuse des sons ambiants pour réduire au minimum les distractions et aider les utilisateurs à se concentrer ou à se reposer.

- Visitez l’App Store pour découvrir des applications et des jeux incroyables qui favorisent l’accès et l’inclusion pour tous, y compris le jeu accessible Unpacking, primé par l’App Store, des applications servant d’outils de communication améliorée et alternative, et bien plus encore.

- L’application Apple TV mettra à l’honneur des créateurs, des artistes et des militants qui partagent avec passion l’expérience des personnes handicapées. Cette année, le thème est « Remaking the world », et chaque histoire invite les téléspectateurs à imaginer une réalité où chacun a le pouvoir d’ajouter sa voix à la grande histoire de l’humanité.

- Apple Books mettra en lumière les expériences vécues du handicap grâce à des collections de récits rédigés à la première personne par des écrivains handicapés, sous forme de livres électroniques et de livres audio.

- Les séances d’entraînement, les méditations et les conseils des entraîneurs d’Apple Fitness+ accueillent les utilisateurs sourds ou malentendants grâce à la langue des signes américaine, et Time to Walk inclut désormais des transcriptions dans l’application Apple Podcasts. Les séances d’entraînement Fitness+ sont toujours accompagnées d’indications audio pour aider les utilisateurs aveugles ou malvoyants, ainsi que de modificateurs permettant à tous de participer, quel que soit leur niveau.

- Les utilisateurs peuvent consulter le site Apple Support pour savoir comment personnaliser leurs appareils Apple au moyen des fonctions d’accessibilité intégrées. De l’adaptation des gestes à la personnalisation de la présentation des renseignements sur l’écran d’un appareil, la liste de lecture Apple Accessibility aidera les utilisateurs à apprendre comment personnaliser les appareils Apple Vision Pro, iPhone, iPad, Apple Watch et Mac pour qu’ils leur conviennent le mieux possible.

Partager l’article

Media

-

Texte de l’article

-

Images de l’article