PRESSEMELDUNG

15. Mai 2024

Apple kündigt neue Bedienungshilfen an, darunter Eye Tracking, Music Haptics, Vocal Shortcuts und mehr

Zu den neuen Bedienungshilfen von Apple, die später in diesem Jahr kommen, gehört Eye Tracking, womit Nutzer:innen des iPad und iPhone ausschließlich mit den Augen navigieren können.

CUPERTINO, KALIFORNIEN Apple hat heute neue Bedienungshilfen angekündigt, die später in diesem Jahr kommen darunter Eye Tracking, womit Nutzer:innen mit körperlichen Einschränkungen ihr iPad oder iPhone mit den Augen steuern können. Music Haptics ist eine neue Möglichkeit für Nutzer:innen, die taub sind oder ein eingeschränktes Hörvermögen haben, Musik mit der Taptic Engine des iPhone zu erleben. Mit Vocal Shortcuts können Nutzer:innen Aufgaben ausführen, indem sie ein bestimmtes Geräusch machen. Vehicle Motion Cues können beim Verwenden von iPhone oder iPad im Auto dabei helfen, Reisekrankheitssymptome zu verringern. Zusätzlich wird es weitere Bedienungshilfen für visionOS geben. Diese Features kombinieren die Power von Apple Hardware und Software und nutzen Apple Chips, künstliche Intelligenz und maschinelles Lernen auf dem Gerät, um das jahrzehntelange Engagement von Apple zu unterstützen, Produkte für alle zu entwickeln.

„Wir sind von der transformative Kraft von Innovationen überzeugt, die das Leben verbessern kann“, sagt Tim Cook, CEO von Apple. „Deshalb setzt sich Apple seit fast 40 Jahren für inklusives Design ein und integriert Bedienungshilfen von Grund auf in unsere Hardware und Software. Wir erweitern ständig die Grenzen des technologisch Machbaren und diese neuen Features zeigen, dass wir allen Nutzer:innen das bestmögliche Erlebnis bieten wollen.“

„Bei Bedienungshilfen gehen wir jedes Jahr neue innovative Wege“, sagt Sarah Herrlinger, Senior Director of Global Accessibility Policy and Initiatives bei Apple. „Die neuen Features werden die Leben vieler Nutzer:innen bereichern und ihnen neue Möglichkeiten bieten, zu kommunizieren, ihre Geräte zu steuern und mobil zu sein.“

Eye Tracking kommt auf iPad und iPhone

Eye Tracking funktioniert mit künstlicher Intelligenz und gibt Nutzer:innen die Möglichkeit, ihr iPad und iPhone nur mit den Augen zu steuern. Das Feature wurde für Personen mit körperlichen Einschränkungen entwickelt und lässt sich über die Frontkamera in wenigen Sekunden einrichten und kalibrieren. Durch das maschinelle Lernen auf dem Gerät bleiben alle Daten, die zum Einrichten und Steuern des Features verwendet werden, sicher auf dem Gerät und werden nicht mit Apple geteilt.

Eye Tracking funktioniert mit iPadOS und iOS Apps und erfordert keine zusätzliche Hardware oder Zubehör. Mit Eye Tracking können Nutzer:innen in Apps navigieren und die Verweilsteuerung nutzen, um Elemente in der App zu aktivieren. So können sie auf zusätzliche Funktionen wie physische Tasten, Streichen und andere Gesten zugreifen – alles nur mit den Augen.

Music Haptics macht Songs für alle zum Erlebnis

Music Haptics ist eine neue Möglichkeit für Nutzer:innen, die taub sind oder ein eingeschränktes Hörvermögen haben, Musik auf dem iPhone zu erleben. Wenn die Bedienungshilfe eingeschaltet ist, gibt die Taptic Engine im iPhone Tippimpulse, Texturen und andere Vibrationsmuster zur Musik aus. Music Haptics funktioniert mit Millionen von Songs aus dem Apple Music Katalog und wird als API für Entwickler:innen verfügbar gemacht, um Musik in Apps für alle zu einem Erlebnis zu machen.

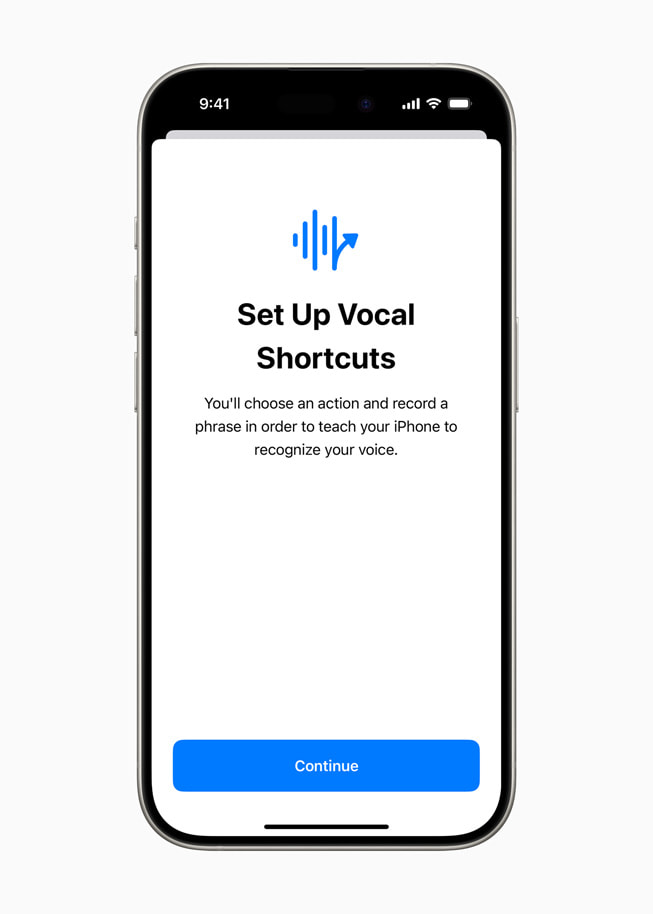

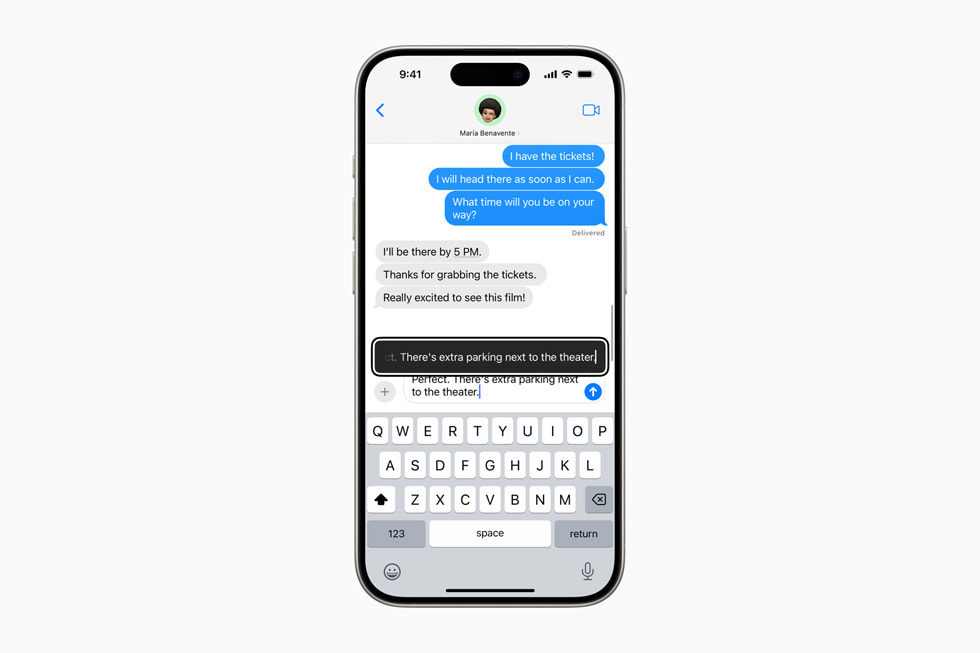

Neue Features für inklusivere Spracherkennung

Mit Vocal Shortcuts können iPhone und iPad Nutzer:innen eigene Äußerungen festlegen, die Siri versteht, um Kurzbefehle zu starten und komplexe Aufgaben auszuführen. Listen for Atypical Speech ist ein weiteres neues Feature für Nutzer:innen, das die Spracherkennung für ein noch breiteres Sprachspektrum ermöglicht. Das Feature nutzt maschinelles Lernen auf dem Gerät, um Sprachmuster zu erkennen. Diese Features sind für Nutzer:innen mit angeborenen oder progressiven Beeinträchtigungen des Sprachvermögens, wie z. B. Zerebralparese, Amyotrophe Lateralsklerose (ALS) oder Schlaganfall, entwickelt worden und bieten ein neues Maß an Anpassung und Kontrolle. Sie bauen auf den Features auf, die in iOS 17 für Nutzer:innen eingeführt worden sind, die nicht sprechen können oder bei denen die Gefahr besteht, dass sie ihr Sprachvermögen verlieren.

„Künstliche Intelligenz hat das Potenzial, Spracherkennung für Millionen von Menschen mit Sprachauffälligkeiten zu verbessern und wir freuen uns, dass Apple diese neuen Bedienungshilfen vorstellt“, sagt Mark Hasegawa-Johnson vom Speech Accessibility Project am Beckman Institute for Advanced Science and Technology der University of Illinois Urbana-Champaign. „Das Speech Accessibility Project ist als breit angelegtes, von der Community unterstütztes Projekt ins Leben gerufen worden, damit Unternehmen und Hochschulen Spracherkennung zuverlässiger und effizienter gestalten können. Und Apple hat dazu beigetragen, das Speech Accessibility Project möglich zu machen.“

Vehicle Motion Cues können Symptome von Reisekrankheit verringern

Vehicle Motion Cues ist ein neues Feature für iPhone und iPad, das Symptome von Reisekrankheit verringern kann. Forschungen haben gezeigt, dass die Reisekrankheit für gewöhnlich durch einen sensorischen Konflikt zwischen dem, was eine Person sieht, und dem, was eine Person fühlt, ausgelöst wird. Das kann es unangenehm machen, iPhone oder iPad im Auto zu verwenden. Mit Vehicle Motion Cues werden animierte Punkte am Displayrand angezeigt, die Veränderungen der Fahrzeugbewegung wiedergeben und so dazu beitragen, den sensorischen Konflikt zu verringern, ohne die Hauptinhalte zu beeinträchtigen. Das Feature verwendet die Sensoren im iPhone und iPad, um Bewegungen während einer Fahrt zu erkennen und darauf zu reagieren. Es kann so eingerichtet werden, dass es automatisch auf dem iPhone erscheint, oder es kann im Kontrollzentrum ein- und ausgeschaltet werden.

CarPlay bekommt Sprachsteuerung und weitere Updates für Bedienungshilfen

CarPlay bekommt neue Bedienungshilfen, darunter Sprachsteuerung, Farbfilter und Geräuscherkennung. Mit der Sprachsteuerung können Nutzer:innen in CarPlay navigieren und Apps bedienen - alles nur mit der Stimme. Die Geräuscherkennung kann Fahrer:innen und Fahrgäste, die taub sind oder ein eingeschränktes Hörvermögen haben, über Mitteilungen auf Autohupen oder Sirenen aufmerksam machen. Für Anwender:innen, die farbenblind sind, machen Farbfilter die Nutzung der CarPlay-Oberfläche visuell einfacher, mit zusätzlichen visuellen Zugänglichkeitsfunktionen wie beispielsweise Fetter Text.

Neue Bedienungshilfen für visionOS

Zu den Bedienungshilfen, die dieses Jahr zu visionOS kommen, gehören systemweite Live Untertitel. So können alle – auch Nutzer:innen, die taub sind oder ein eingeschränktes Hörvermögen haben – gesprochenen Dialogen in Live-Unterhaltungen oder in Audioteilen von Apps besser folgen. Mit Live Untertiteln für FaceTime in visionOS wird es für viele Nutzer:innen noch einfacher, mit der Vision Pro mit anderen in Verbindung zu bleiben und zusammenzuarbeiten. In der Apple Vision Pro wird es möglich sein, die Untertitel über die Fensterleiste in Apple Immersive Video zu verschieben. Und es kommt Unterstützung für zusätzliche Hörgeräte „Made for iPhone“ und Cochlea-Gehörprozessoren hinzu. Zu den Bedienungshilfen für Sehvermögen kommen Reduce Transparency, Smart Invert und Dim Flashing Lights hinzu – für Nutzer:innen, die ein eingeschränktes Sehvermögen haben oder helles bzw. schnell blinkendes Licht reduzieren möchten.

Diese Features kommen zu den vielen Bedienungshilfen hinzu, die bereits in der Apple Vision Pro verfügbar sind. Das ermöglicht ein flexibles Eingabesystem und eine intuitive Oberfläche für viele unterschiedliche Nutzer:innen. Mit Features wie VoiceOver, Zoom und Farbfiltern bekommen auch Nutzer:innen, die blind sind oder ein eingeschränktes Sehvermögen haben, Zugang zu räumlichem Computing, während Features wie Geführter Zugriff Nutzer:innen mit kognitiven Einschränkungen unterstützen können. Anwender:innen können die Vision Pro mit den Augen, Händen und ihrer Stimme steuern – mit Bedienungshilfen wie Schaltersteuerung, Geräuschaktionen und Verweilsteuerung, die Personen mit körperlichen Behinderungen unterstützen.

„Die Apple Vision Pro bietet ohne Zweifel die zugänglichste Technologie, die ich je verwendet habe“, sagt Ryan Hudson-Peralta, Produktdesigner aus Detroit, Accessibility Consultant und Mitgründer von Equal Accessibility LLC. „Als jemand, der ohne Hände geboren wurde und nicht laufen kann, weiß ich, dass die Welt in erster Linie nicht für Menschen wie mich geschaffen worden ist. Darum ist es toll zu sehen, dass visionOS einfach funktioniert. Es zeigt, wie stark und wichtig zugängliches und inklusives Design ist.“

Weitere Updates

- Für Nutzer:innen, die blind sind oder ein eingeschränktes Sehvermögen haben, kommen in VoiceOver neue Stimmen, ein flexibler Voice Rotor, angepasste Lautstärkesteuerung und die Möglichkeit, Tastaturkurzbefehle für VoiceOver auf dem Mac anzupassen.

- Die Lupe bekommt einen neuen Lesemodus und die Option, den Erkennungsmodus einfach mit der Actiontaste zu starten.

- Anwender:innen, die Braille nutzen, erhalten eine neue Möglichkeit, die Braillebildschirmeingabe zu öffnen und geöffnet zu lassen, für schnellere Steuerung und schnellere Texteingabe. Japanisch wird als Sprache für die Braillebildschirmeingabe verfügbar sein. Und es kommen Unterstützung für mehrzeiliges Braille mit Dot Pad sowie die Option, verschiedene Ein- und Ausgabetabellen zu wählen.

- Für Nutzer:innen mit eingeschränktem Sehvermögen kann Hover Typing bei der Eingabe in Textfelder größeren Text in der bevorzugten Schriftart und -farbe anzeigen.

- Für Anwender:innen, bei denen die Gefahr besteht, dass sie ihre Sprachfähigkeit verlieren, wird Eigene Stimme in Mandarin verfügbar sein. Nutzer:innen, die Schwierigkeiten beim Aussprechen oder Lesen ganzer Sätze haben, können eine eigene Stimme mit verkürzten Ausdrücken erstellen.

- Für Nutzer:innen, die nicht sprechen, bringt die Live Sprachausgabe Kategorien und gleichzeitige Kompatibilität mit Live Untertiteln.

- Anwender:innen mit körperlichen Einschränkungen bietet Virtuelles Trackpad für AssistiveTouch die Möglichkeit, ihr Gerät über einen anpassbaren Bereich auf dem Display zu bedienen, der als Trackpad funktioniert.

- Die Schaltersteuerung erhält die Option, die Kameras in iPhone und iPad zu verwenden, um Fingertipp-Gesten als Schalter zu erkennen.

- Die Sprachsteuerung bietet Unterstützung für angepassten Wortschatz und komplexe Wörter.

Welttag der Barrierefreiheit bei Apple

Anlässlich des Welttags der Barrierefreiheit stellt Apple diese Woche neue Features, kuratierte Sammlungen und mehr vor:

- Im Mai wird es in ausgewählten Apple Stores kostenlose Sessions geben, in denen Kund:innen die Bedienungshilfen ihrer liebsten Produkte entdecken und ausprobieren können. Im Apple Store Piazza Liberty in Mailand wird das Talent hinter der viralen Kampagne „Assume that I can“ anlässlich des Welt-Down-Syndrom-Tags zu Gast sein. Und mit Gruppenreservierungen für Today at Apple Sessions, die das ganze Jahr über möglich sind, werden die Apple Stores zu einem Ort, an dem sich Freund:innen, Familien, Schulen und Community Gruppen gemeinsam über Bedienungshilfen informieren können.

- Zu Kurzbefehlen kommen beruhigende Klänge hinzu, die Ambient-Sounds abspielen, um Ablenkungen zu verringern und dabei zu helfen, sich zu konzentrieren oder zur Ruhe zu kommen.

- Im App Store gibt es fantastische Apps und Spiele, die Barrierefreiheit und Inklusion fördern, wie das App Store Award-prämierte Game „Unpacking“, Apps sowie Tools für erweiterte und alternative Kommunikation (AAC) und mehr.

- Die Apple TV App stellt herausragende Creator:innen, Darsteller:innen und Aktivist:innen vor, die die Erfahrungswelten von Menschen mit Behinderung teilen. Das Thema in diesem Jahr heißt Remaking the World. Jede Geschichte bildet dabei eine eigene Vision einer Welt ab, in der die Stimmen aller gehört werden.

- In Apple Bücher gibt es kuratierte Sammlungen mit Geschichten, in denen Autor:innen mit Behinderung von ihren gelebten Erfahrungen erzählen, als eBook und Hörbuch.

- Für Nutzer:innen, die taub sind oder ein eingeschränktes Hörvermögen haben, gibt es in Apple Fitness+ Trainings, Meditationen und Tipps von Trainer:innen in amerikanischer Gebärdensprache. Und Zeit fürs Gehen enthält jetzt Transkripte in der Apple Podcasts App. Fitness+ Trainings enthalten immer Audiohinweise für Nutzer:innen, die blind sind oder ein eingeschränktes Sehvermögen haben, sowie Modifier, damit alle mittrainieren können.

- Vom Apple Support erfahren Nutzer:innen, wie sie ihre Apple Geräte mit integrierten Bedienungshilfen anpassen können. Vom Anpassen von Gesten bis zur Darstellung von Informationen auf dem Display – die Apple Accessibility Playlist zeigt Nutzer:innen, wie sie Apple Vision Pro, iPhone, iPad, Apple Watch und Mac Computer so anpassen können, wie es für sie am besten ist.

Artikel teilen

Media

-

Text dieses Artikels

-

Bilder zu dieser Pressemeldung